qinglong青龙面板v2.20.1鉴权漏洞

半夜躺在床上睡不着的时候,手机弹出了青龙面板的登录通知,一看日志就觉得不对劲,打开电脑一看,原来是青龙面板出现了0day漏洞,被人攻击了...看日志还运行了生成Token的任务,并且还主动删除了日志。我这个部署的时候是跑在docker里面的,但是偷懒没有修改默认的端口号。Github上已经有明确的复现方法了:0day 青龙面板 最新版本 鉴权绕过导致 RCE · Issue #2934 · why

半夜躺在床上睡不着的时候,手机弹出了青龙面板的登录通知,一看日志就觉得不对劲,打开电脑一看,原来是青龙面板出现了0day漏洞,被人攻击了...看日志还运行了生成Token的任务,并且还主动删除了日志。我这个部署的时候是跑在docker里面的,但是偷懒没有修改默认的端口号。Github上已经有明确的复现方法了:0day 青龙面板 最新版本 鉴权绕过导致 RCE · Issue #2934 · why

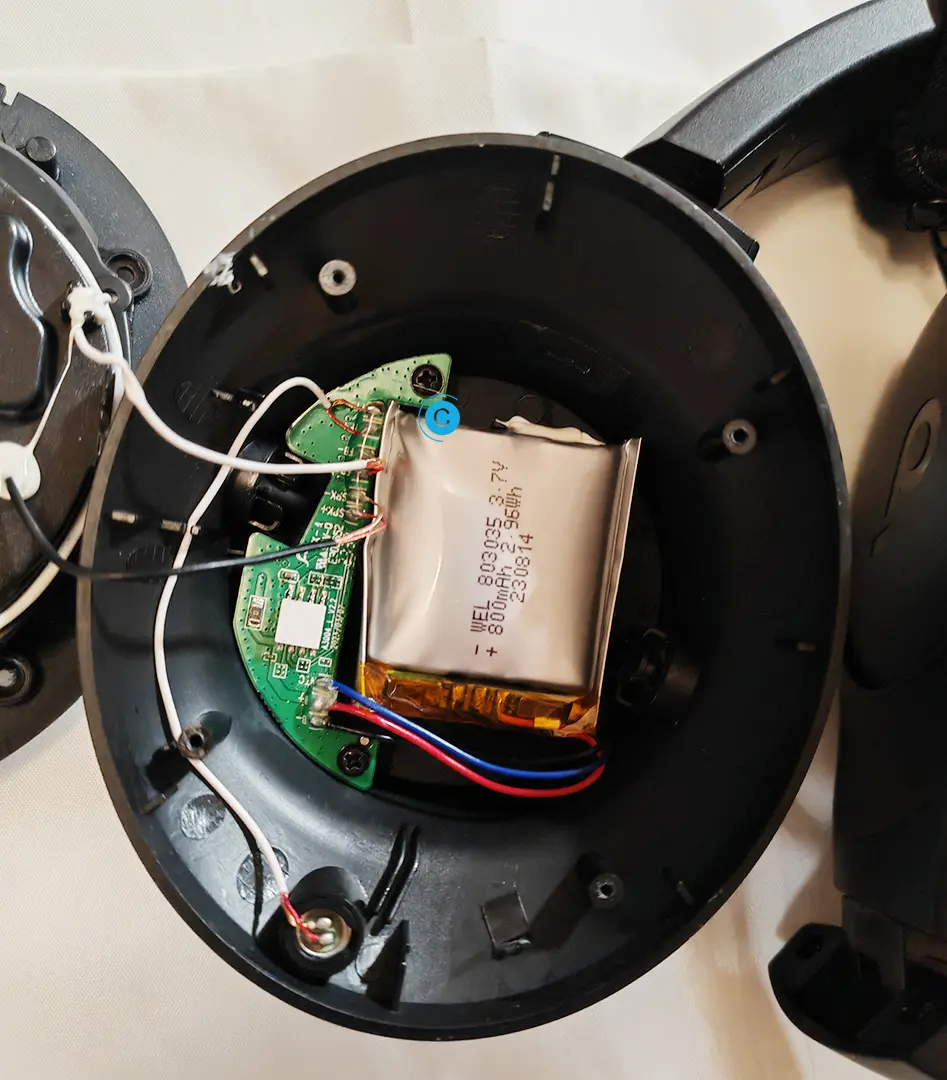

最近感觉这耳机续航实在是太差,根本无法充满,充几个小时也只能用几分钟,想着就换一下里面的电池,大概买来用了一年多吧,过保修是肯定的。然后打开一看就这样了,电池已经鼓包了。白色的连接线出厂的时候就被压扁了。实际上电池是23年出厂的,也差不多两年半吧。换个角度,从这个角度看电池已经鼓得不能再鼓了,确实要立即更换电池。看了一下网上的拆解图:拆解报告:Soundcore声阔Life Q20i头戴式降噪耳机

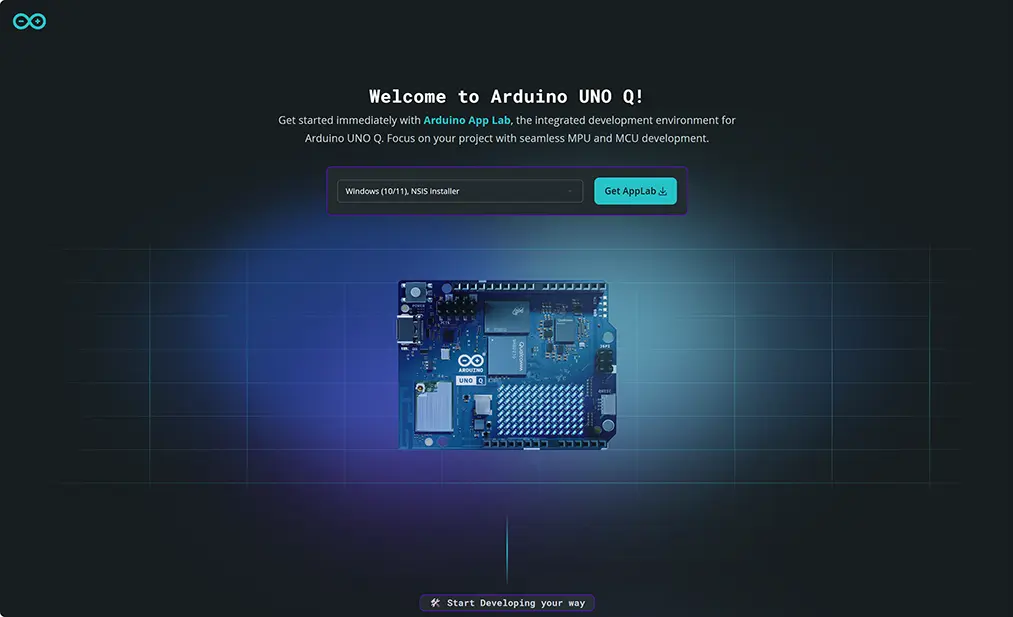

最近入手了全新的 Arduino UNO Q——这是高通收购 Arduino 后推出的首款产品。虽然 Arduino 的核心优势一直更偏软件生态,但官方开发板往往也代表着平台的技术走向。UNO Q 搭载 QRB2210 处理器,明显体现出 Arduino 正在把产品线从传统单片机进一步拓展到 ARM 端。类似地,自从树莓派推出 RP2040 之后,也在从 ARM 阵营进入到单片机市场,扩展布局。设

因为一个项目使用到了aws-sdk-cpp,Amazon Web Services在C++下的依赖库,正好本文记录一下在Windows平台下的编译步骤。本次的编译平台是:Visual Studio 2022,Windows 11,aws-sdk-cpp的版本是 1.11.285更多介绍和文档,可以看项目首页:aws/aws-sdk-cpp: AWS SDK for C++适用于 C++ 的 AWS

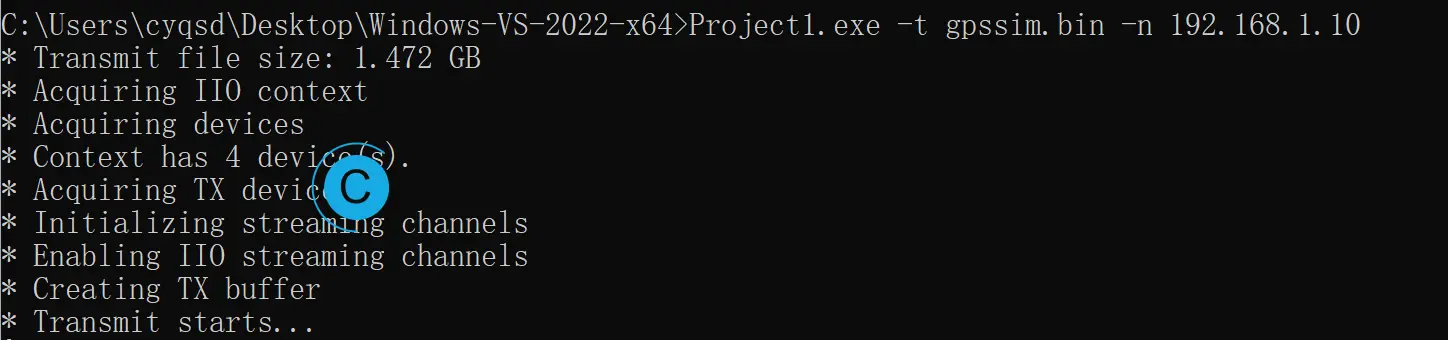

在前文中捣鼓了hackrf使用gps-sdr-sim - cyqsd's blog,虽然hackrf one有着诸多优点,但是毕竟收发不能同时进行的硬件限制在哪里,真要进行一些测试,还是没有那么方便的,这个时候使用Pluto SDR就是更好的选择。可以使用以前弄的zynq-zc702+fmcomms2+Linux环境搭建和编译 - cyqsd's blog进行测试,因为里面已经是Pluto SDR

VirtualWife是一个开源的虚拟数字人项目。其中数字人生成的部分是基于ChatVRM的虚拟主播项目,语音是由多个TTS驱动,文字生成可以使用LLM。yakami129/VirtualWife: VirtualWife是一个虚拟数字人项目,支持B站直播,支持openai、ollamapixiv/ChatVRM增加domain-chatbot/apps/speech/tts/bytedance_

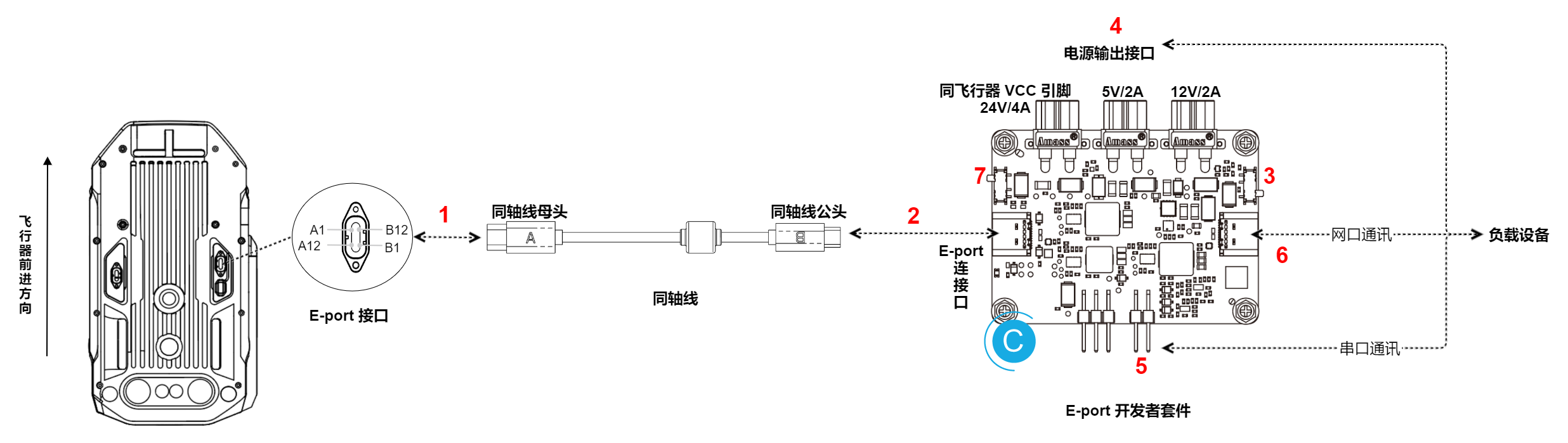

最近捣鼓了大疆 DJI的Payload SDK,大疆其实已经提供了非常详细的部署文档可供参考,在Payload SDK中,推荐的硬件是Jetson Nano和树莓派 4B。系统安装我这里使用的硬件是Jetson Orin Nano 4G,底板不是官方的,是淘宝购入的。直接从英伟达的官网可以下载:SDK Manager | NVIDIA Developer,安装最新版本的系统,但是注意JetPack

本次捣鼓了PJSUA2和PJSIP,用于测试VoIP 软电话功能。PJSUA2 API 是一个基于 PJSUA-LIB API 的 C++ 库,它提供了高层次的 API,用于构建会话初始协议(SIP)多媒体用户代理应用程序(也称为 VoIP 软电话)。折腾过程参考了下面的教程:Ubuntu 18.04 下编译 Pjsua2用arm-none-linux-gnueabi-gcc交叉编译pjsip源码