使用rembg-trainer进行模型训练

在前面的文章中使用了rembg,一个非常好用且开源的图像分割工具:使用rembg并捣鼓ONNX Runtime - cyqsd's blog,也提到了birefnet、u2net_xxx等适用于各类场景的模型,但毕竟那都是人家预训练的模型,并不能涵盖现实使用时的所有场景,并且要达到较好效果的预训练模型,往往体积也很大,不利于轻量化的使用。那这时可以考虑自己构建训练集,在issues的提问中有人问到

在前面的文章中使用了rembg,一个非常好用且开源的图像分割工具:使用rembg并捣鼓ONNX Runtime - cyqsd's blog,也提到了birefnet、u2net_xxx等适用于各类场景的模型,但毕竟那都是人家预训练的模型,并不能涵盖现实使用时的所有场景,并且要达到较好效果的预训练模型,往往体积也很大,不利于轻量化的使用。那这时可以考虑自己构建训练集,在issues的提问中有人问到

当同一台电脑需要多个版本的cuda环境,并且需要使用docker时,可以考虑使用NVIDIA Container 运行时和NVIDIA在docker上发布的官方cuda容器,减少环境的配置成本。NVIDIA Container 运行时库安装nvidia-container-runtime 和 nvidia-docker 均已停止维护,相关功能完全由 libnvidia-container 替代。具

RAGFlow是一个基于深度文档理解的开源 RAG(检索增强生成)引擎。当与大型语言模型(LLMs)结合时,它能够提供可靠的问答能力,并且可以引用各种复杂格式数据中的内容作为依据。现目前也算是主流的开源知识库管理应用之一,安装过程中需要一堆依赖,好在有docker让步骤变得容易。1.硬件需求这个安装必须使用docker了,手动部署安装过于折磨。官方提供了详细的安装教程,Quick start |

本次捣鼓的是Dify。也是一个完整的知识库解决方案。本文档更新时,最新版本为0.15.3。Dify 是一款开源的大语言模型(LLM) 应用开发平台。它融合了后端即服务(Backend as Service)和 LLMOps 的理念,使开发者可以快速搭建生产级的生成式 AI 应用。官方提供了完善的部署教程,依旧是推荐使用docker进行部署。Docker Compose 部署 | Dify1.拉取G

MaxKB是和1panel一个团队开发的,想起来了以前使用cpanel、da、WDCP、AppNode啥的面板时候了,一转眼又已经过去好多年了。现在时代发展了,来做知识库面板好像也不是不行,算是很对口了。MaxKB也提供了很完善的安装文档,我在此处选择的是离线安装,步骤可以参考官方文档:离线安装 - MaxKB 文档写本文时,最新的版本是1.10.1-LTS 版:下载后是-offline.tar.

本次捣鼓的是Open WebUI,开源的AI托管平台,带有知识库应用。Open WebUI是一个可扩展、功能丰富且用户友好的自托管 AI 平台,设计为完全离线运行。它支持多种大型语言模型(LLM)运行器,如 Ollama 和与 OpenAI 兼容的 API,并内置了 RAG 推理引擎,使其成为强大的 AI 部署解决方案。官方提供了很详细的安装方法: 快速上手 | Open WebUI比较常规的安装

LLaMA-Factory提供了简单易用的WebUI对模型进行微调,是一个非常好用的微调平台。LLaMA Factory 是一个简单易用且高效的大型语言模型(Large Language Model)训练与微调平台。通过 LLaMA Factory,可以在无需编写任何代码的前提下,在本地完成上百种预训练模型的微调官方提供了详细的教程:安装 - LLaMA Factory。# 拉取源 git clo

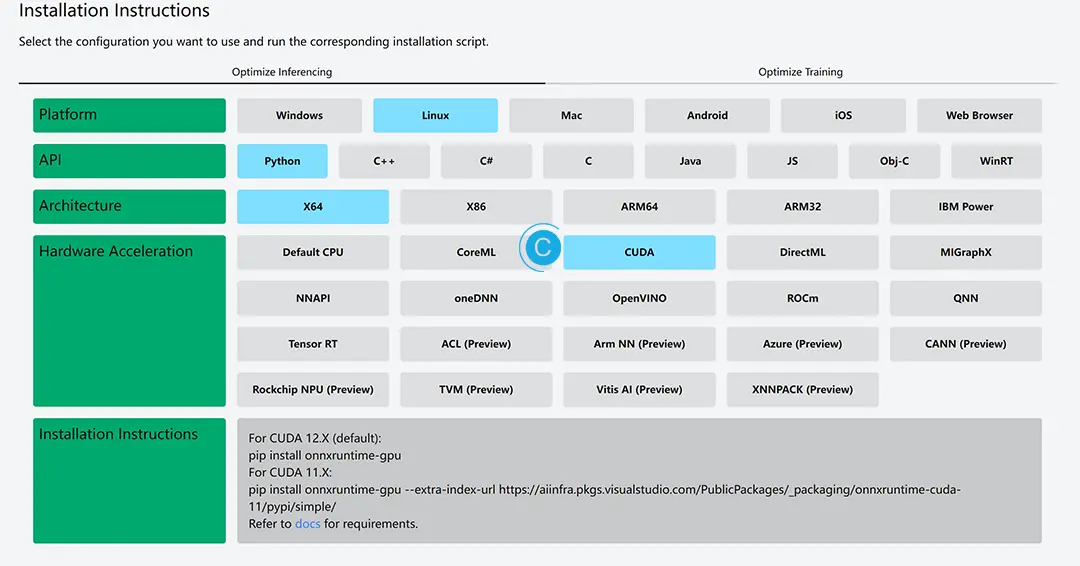

最近捣鼓了一下Python下的开源库rembg,一个非常好用的背景移除工具,支持各种各样的物体用于移除背景。并且支持多种模型,还支持微调训练。具体可以看官网:danielgatis/rembg: Rembg is a tool to remove images background。本文使用的环境是ubuntu 22.04,CUDA 12.2。环境准备首先需要知道自己的硬件环境(CUDA)和ONN