OpenWebUI部署和使用体验

本次捣鼓的是Open WebUI,开源的AI托管平台,带有知识库应用。

Open WebUI是一个可扩展、功能丰富且用户友好的自托管 AI 平台,设计为完全离线运行。它支持多种大型语言模型(LLM)运行器,如 Ollama 和与 OpenAI 兼容的 API,并内置了 RAG 推理引擎,使其成为强大的 AI 部署解决方案。

官方提供了很详细的安装方法:

比较常规的安装方式是Python直装和docker部署:

直接运行docker run -d -p 3000:8080 --gpus all -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:cuda。Nvidia GPU 支持根据显卡安装情况开启,--gpus all。

源的话在ghcr.io(GitHub)上,根据情况是否使用镜像地址,可以使用:容器镜像加速服务(不确定多久会失效,失效就更换其他的),直接替换URL即可。

docker run -d -p 3000:8080 --gpus all -v open-webui:/app/backend/data --name open-webui ghcr.mirrorify.net/open-webui/open-webui:cudaCONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

0e2236904b16 1panel/maxkb:v1.10.1-lts "bash -c 'rm -f /opt…" 9 days ago Up 9 days (healthy) 5432/tcp, 0.0.0.0:8085->8080/tcp, :::8085->8080/tcp maxkb

e4394ff18c59 1panel/maxkb:v1.10.1-lts "docker-entrypoint.s…" 9 days ago Up 9 days (healthy) 0.0.0.0:5432->5432/tcp, :::5432->5432/tcp, 8080/tcp pgsql

b64535eb4e15 ghcr-pull.ygxz.in/open-webui/open-webui:main "bash start.sh" 13 days ago Up 13 days (healthy) 0.0.0.0:3000->8080/tcp, :::3000->8080/tcp open-webui配置ollama

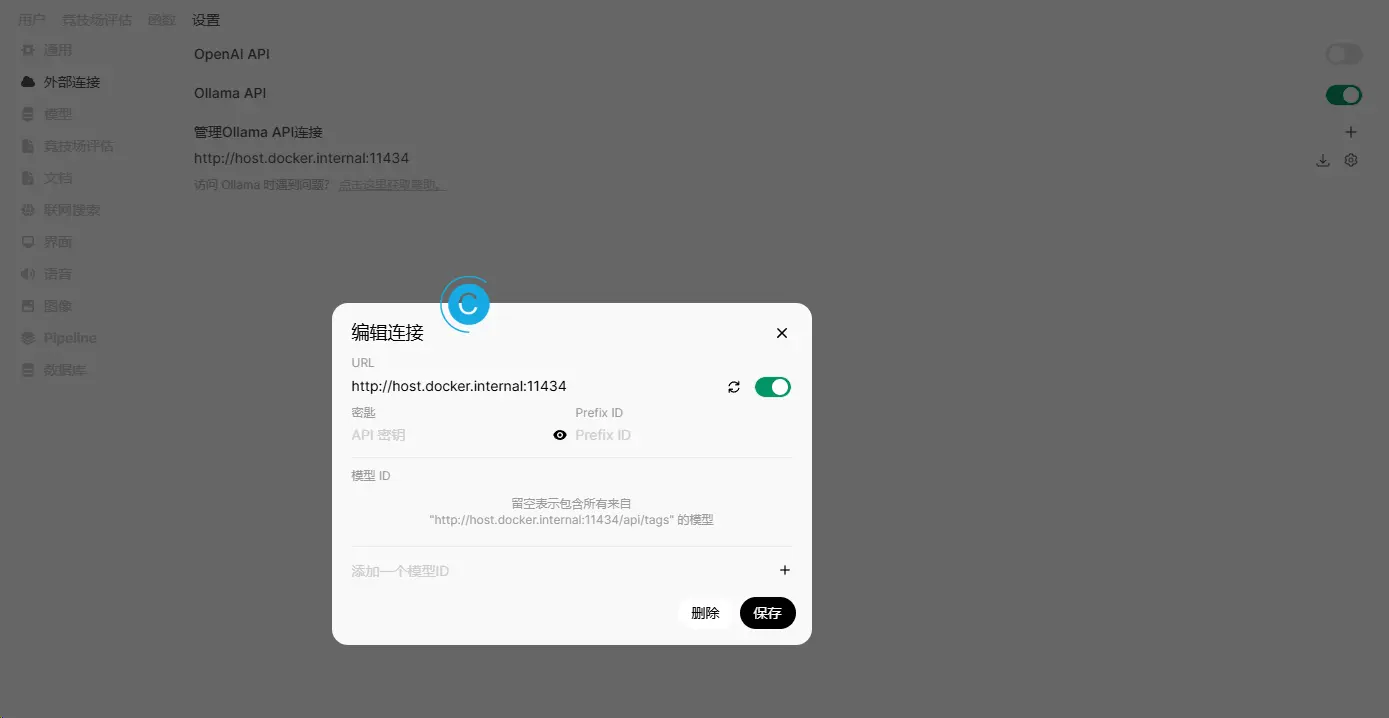

完成上面的步骤后,访问:http://你的IP地址:3000/,登录后进行配置ollama,官方提供了教程: Ollama 入门 | Open WebUI。

因为Open WebUI是在docker上,此处的IP要么填局域网的IP,要么是http://host.docker.internal:11434,11434是ollama安装时的端口,根据实际情况调整。

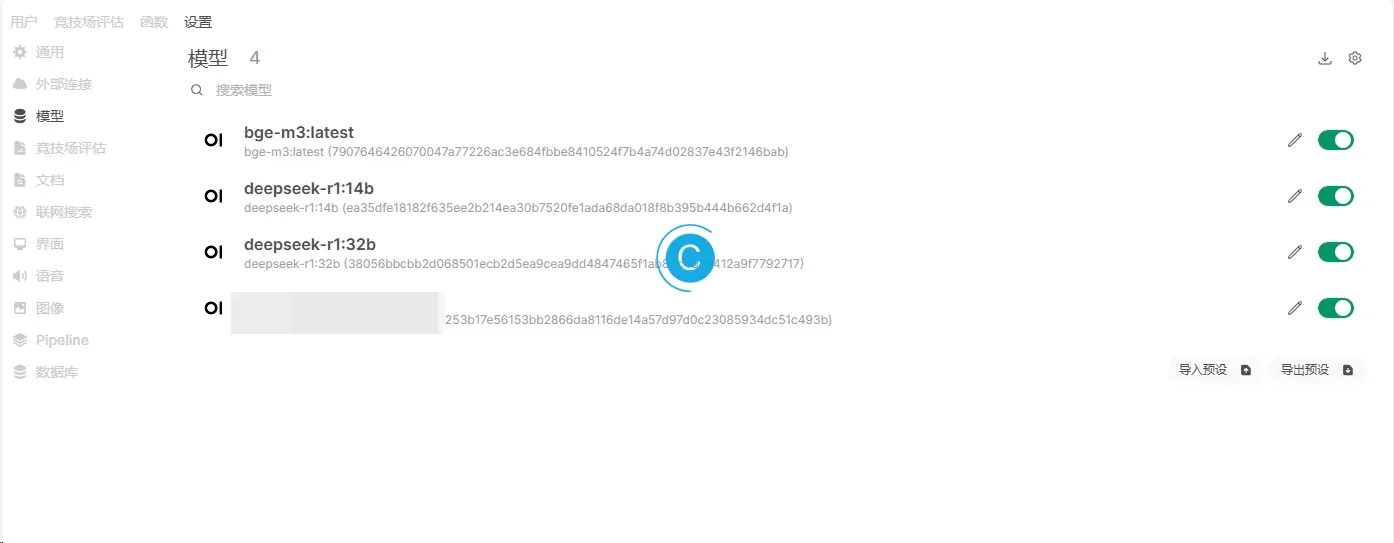

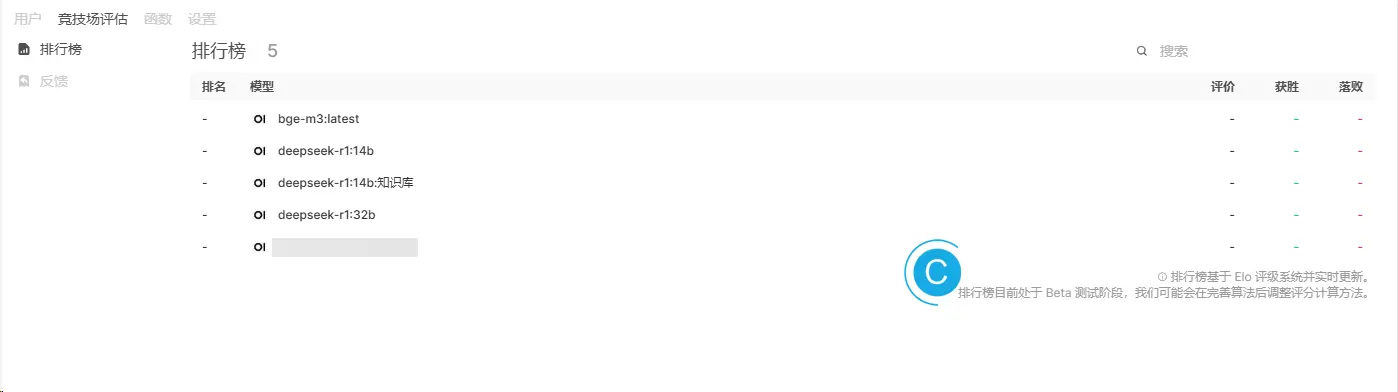

此处测试的模型是:

- 嵌入模型:bge-m3:latest

- 推理模型:deepseek-r1:32b 和 14b

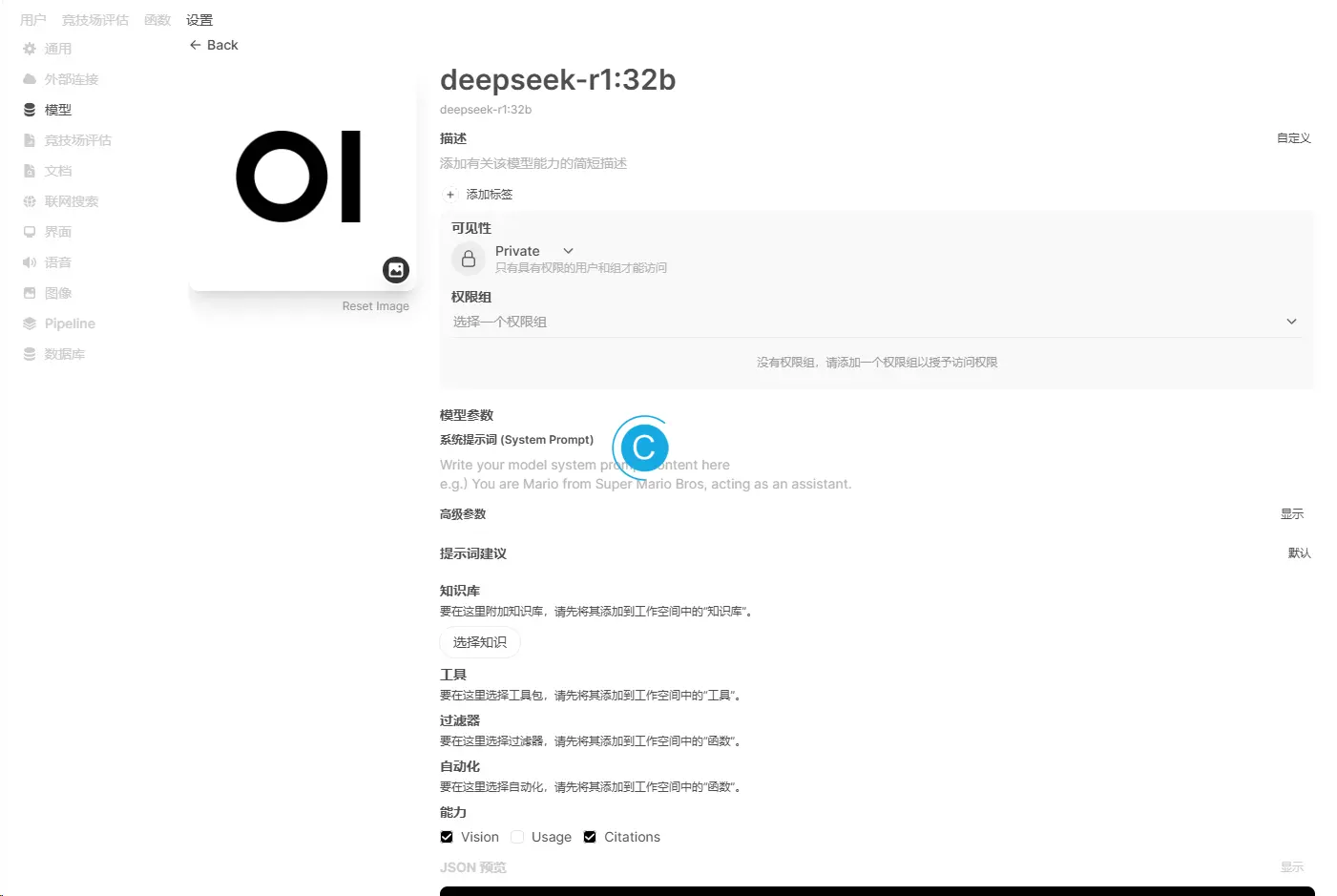

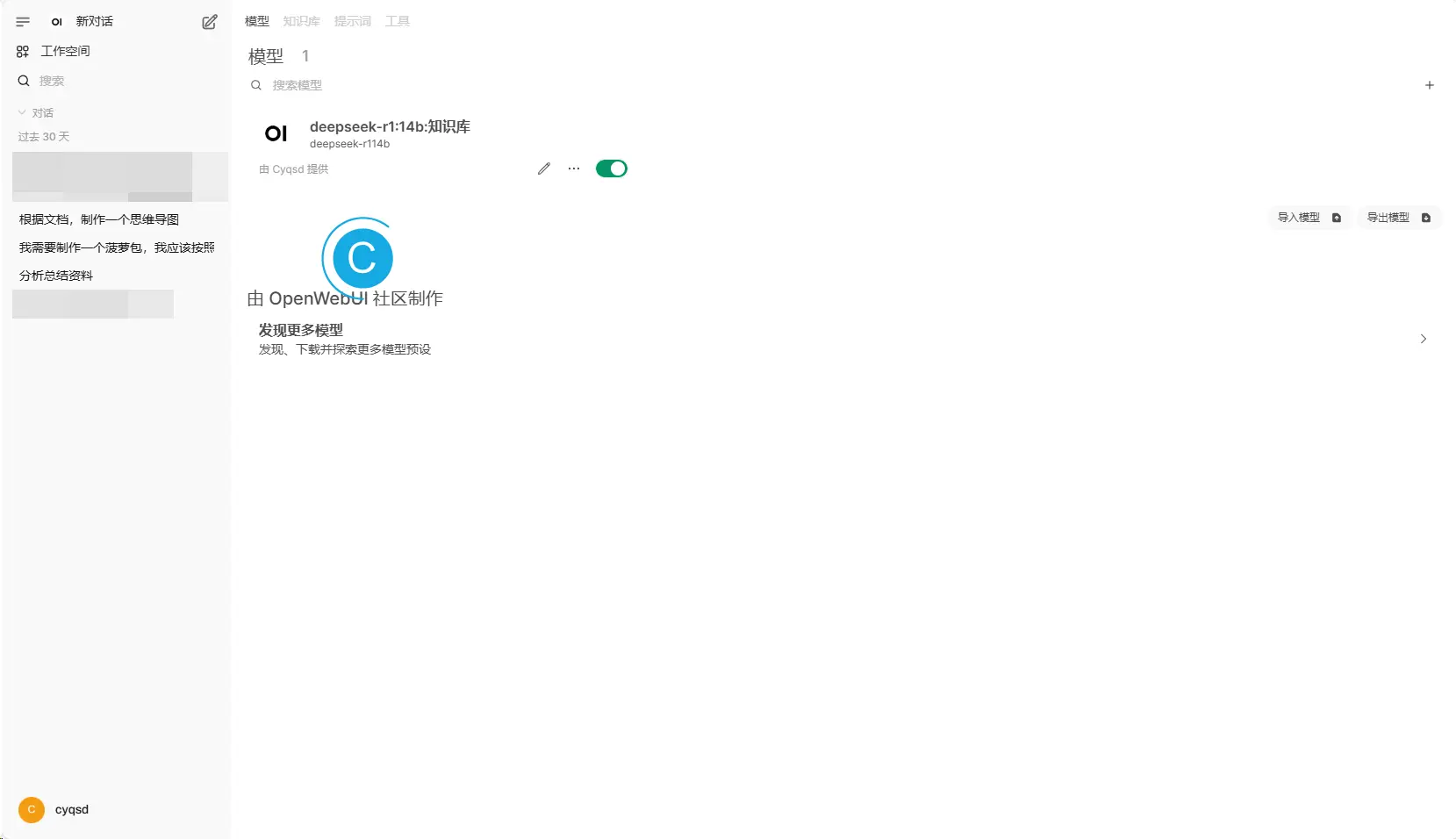

编辑模型所关联的知识库。

使用体验

实际使用下来,本地化还是覆盖很全的。

AI对话游乐场是Open WebUI的亮点之一,可以让多种模型在一起对话评分。

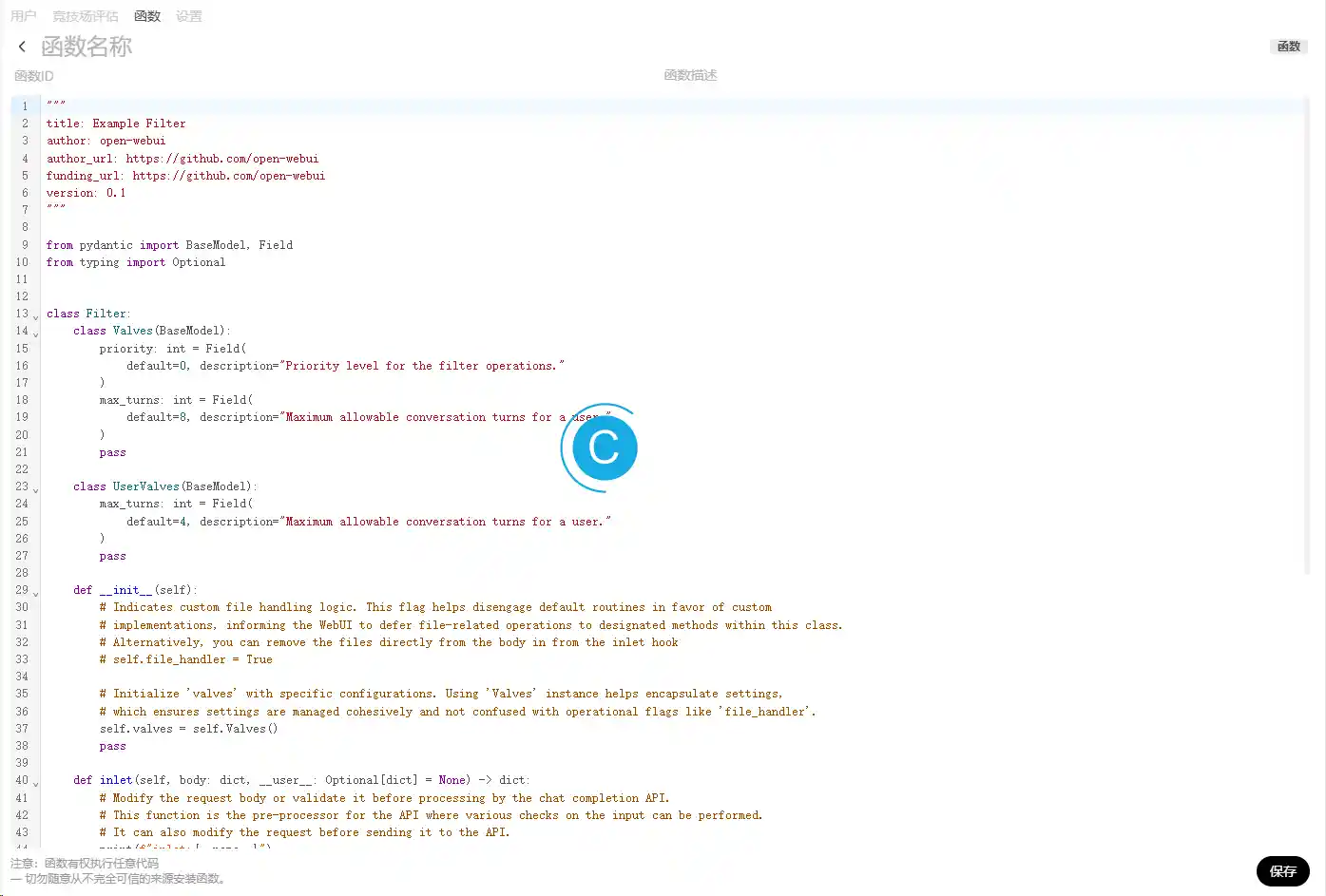

函数是可自定义的对内容进行处理,但是没有图形化的流程编辑工具。

系统配置里面功能蛮齐全的。

支持通过API进行连接。

本作品采用 知识共享署名-相同方式共享 4.0 国际许可协议 进行许可。